Google Cloudは、本番環境でのRayワークロードのスケーリングを簡素化する、GKE上の新しいRay Operatorの提供を発表しました。この統合により、生成AIモデルのサイズとスコープが拡大し続ける中、組織は複数のマシン間でタスクを効率的に分散させることができます。

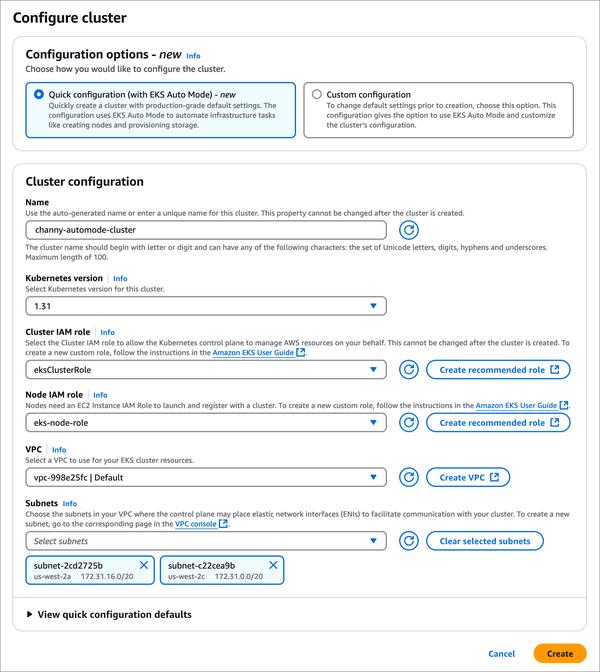

私が特に注目したのは、Ray Operatorの使いやすさです。宣言型APIを有効にすることで、ユーザーは単一の構成オプションを使用してGKE上のRayクラスターを管理できるようになりました。これにより、セットアッププロセスが簡素化され、開発者はAI/MLアプリケーションの構築とデプロイに集中できます。

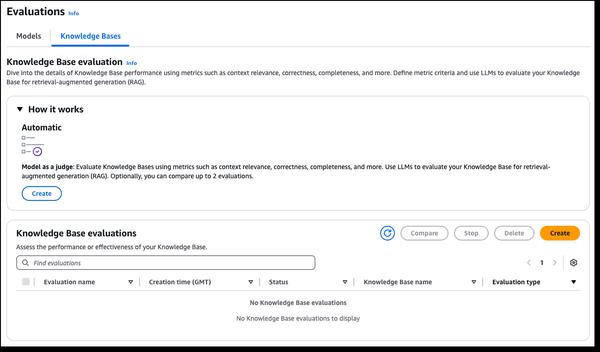

さらに、この新しいアドオンは、ロギングやモニタリングなどの機能をサポートしており、ユーザーはアプリケーションのパフォーマンスに関する貴重な洞察を得ることができます。Cloud LoggingとCloud Monitoringの統合により、ボトルネックやリソースエラーを簡単に特定できるため、Rayワークロードの円滑な運用が保証されます。

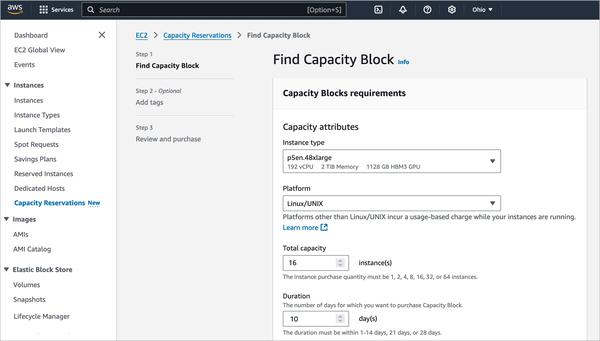

最後に、TPUのサポートが追加されたことも歓迎すべきことです。GoogleのAI Hypercomputerアーキテクチャを活用することで、ユーザーはトレーニングや推論のタスクを高速化するためにTPUの能力を活用できるようになりました。この機能は、大規模なモデルを扱う組織や、処理時間の短縮を必要とする組織にとって特に有益です。

全体的に見て、GKE上の新しいRay Operatorは、分散コンピューティングをより利用しやすくするための重要な一歩と言えます。クラスター管理の簡素化、リソースモニタリングの強化、特殊なハードウェアアクセラレータのサポートにより、Google Cloudは、組織が本番環境でAI/MLのためのRayの可能性を最大限に引き出すことを可能にします。